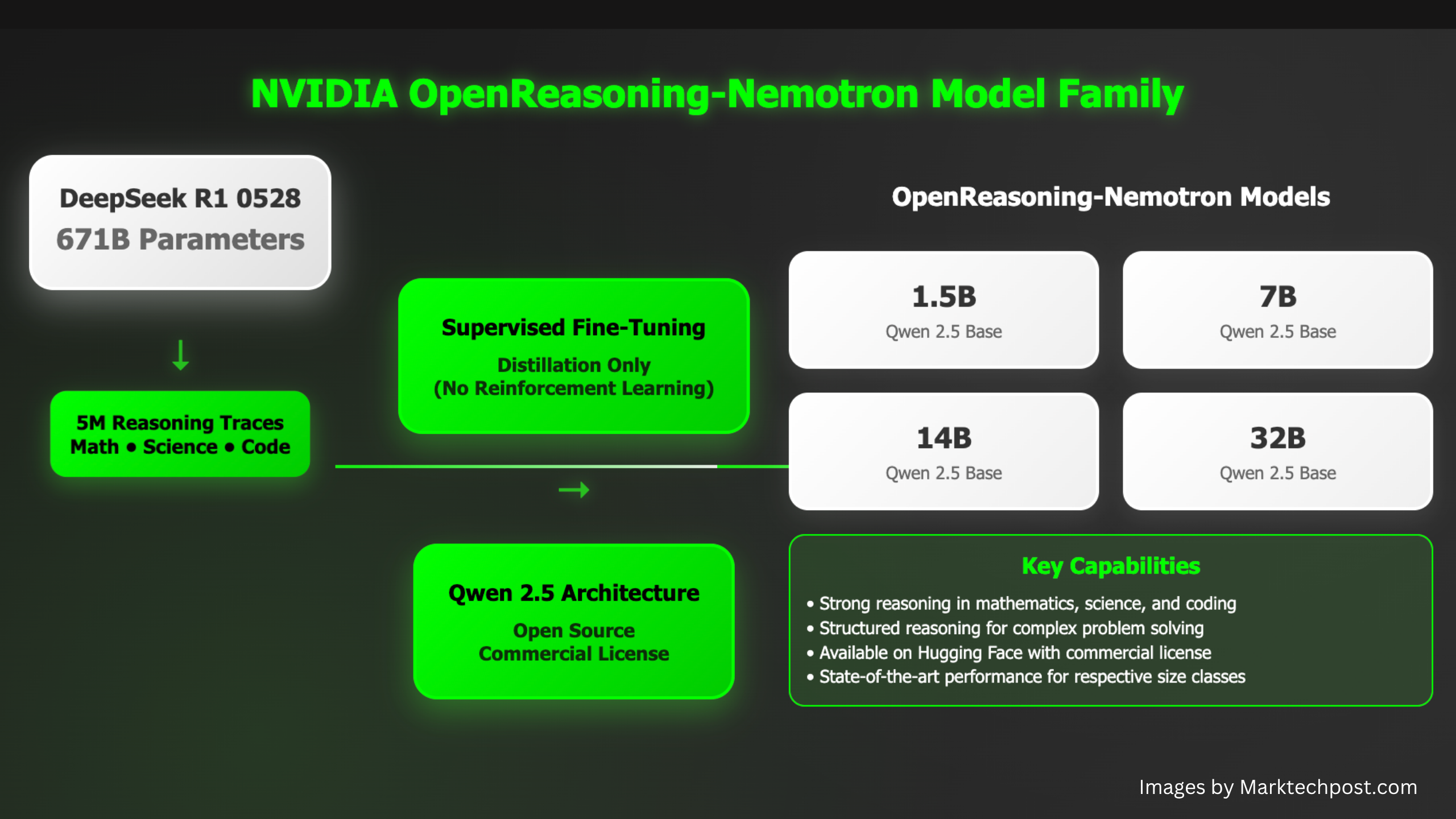

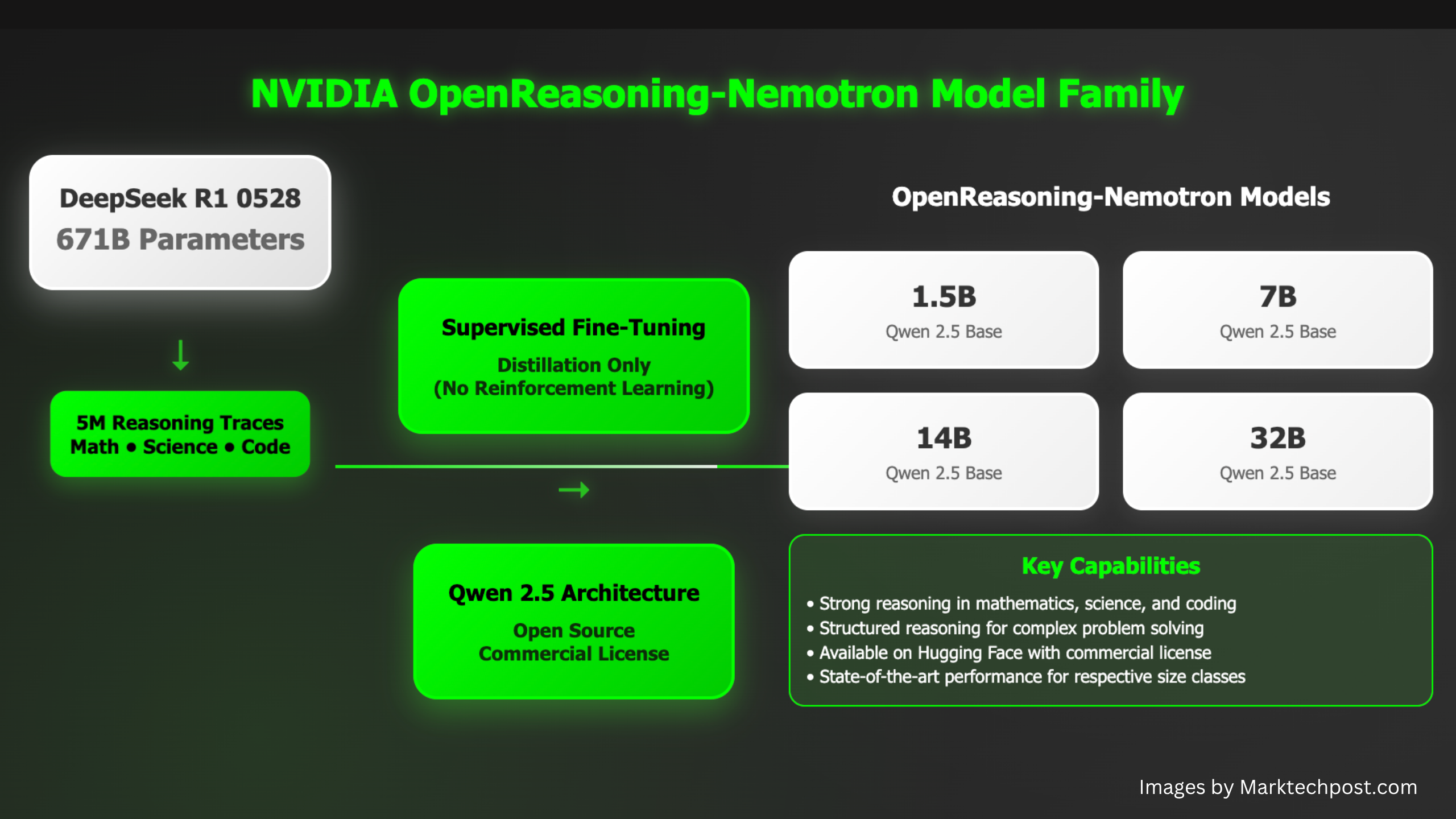

Команда NVIDIA AI анонсировала OpenReasoning-Nemotron — семейство больших языковых моделей (LLM), оптимизированных для решения сложных задач в области математики, науки и программирования. Эта линейка включает версии с 1.5B, 7B, 14B и 32B параметрами, которые были дистиллированы из модели DeepSeek R1 0528 (671B), сохранив её высокий уровень логического мышления в более компактных и эффективных моделях.

Этот релиз укрепляет позиции NVIDIA как ключевого участника open-source-экосистемы LLM, предлагая модели с передовой производительностью, доступные для коммерческого использования и размещённые на платформе Hugging Face.

Архитектура и особенности моделей

Дистилляция на основе DeepSeek R1 0528 (671B)

Основу OpenReasoning-Nemotron составляет стратегия дистилляции, которая переносит способности к логическому мышлению из гигантской модели DeepSeek R1 (671B параметров) в более компактные архитектуры. В процессе упор делается на обобщение логических структур, а не просто предсказание токенов, что позволяет небольшим моделям эффективно справляться со сложными аналитическими задачами.

Обучающий набор данных сфокусирован на математике, естественных науках и программировании, что делает модели особенно полезными в этих областях.

Доступные варианты моделей

| Название модели | Параметры | Основное применение | Страница на Hugging Face |

|---|---|---|---|

| OpenReasoning-Nemotron-1.5B | 1.5B | Базовые задачи логического вывода | Ссылка |

| OpenReasoning-Nemotron-7B | 7B | Средний уровень сложности, математика и код | Ссылка |

| OpenReasoning-Nemotron-14B | 14B | Продвинутые аналитические задачи | Ссылка |

| OpenReasoning-Nemotron-32B | 32B | Максимальная производительность в логически сложных сценариях | Ссылка |

Все модели совместимы с архитектурой трансформеров, поддерживают квантование FP16/INT8 и оптимизированы для работы на GPU NVIDIA и фреймворке NeMo.

Результаты тестирования

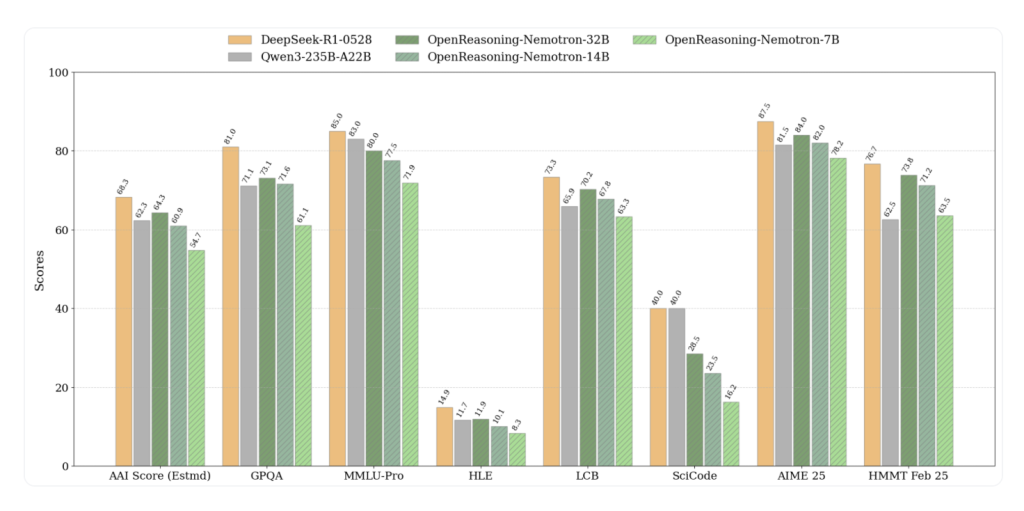

Эти модели устанавливают новые рекорды pass@1 для своего класса в различных тестах на логическое мышление:

| Модель | GPQA | MMLU‑PRO | HLE | LiveCodeBench | SciCode | AIME24 | AIME25 | HMMT Feb 2025 |

| 1.5B | 31.6 | 47.5 | 5.5 | 28.6 | 2.2 | 55.5 | 45.6 | 31.5 |

| 7B | 61.1 | 71.9 | 8.3 | 63.3 | 16.2 | 84.7 | 78.2 | 63.5 |

| 14B | 71.6 | 77.5 | 10.1 | 67.8 | 23.5 | 87.8 | 82.0 | 71.2 |

| 32B | 73.1 | 80.0 | 11.9 | 70.2 | 28.5 | 89.2 | 84.0 | 73.8 |

Все показатели приведены для pass@1 без использования GenSelect.

GenSelect (режим высокой нагрузки)

Применение Generative Selection с 64 кандидатами («GenSelect») дополнительно повышает производительность, особенно для 32B-версии:

- 32B демонстрирует: AIME24 89.2 → 93.3, AIME25 84.0 → 90.0, HMMT 73.8 → 96.7, LiveCodeBench 70.2 → 75.3.

Это подтверждает высокую эффективность моделей в сложных сценариях.

Данные обучения и специализация

Обучающий набор представляет собой тщательно отобранное подмножество данных DeepSeek R1 0528. Ключевые особенности:

- Высококачественные данные по математике, науке и компьютерным дисциплинам.

- Тонкая настройка с продуманными промптами для улучшения многошаговых рассуждений.

- Акцент на логическую согласованность, соблюдение ограничений и символьные вычисления.

Такой подход обеспечивает высокую эффективность в реальных задачах, встречающихся в академической и прикладной сфере.

Открытость и интеграция

Все четыре модели OpenReasoning-Nemotron выпущены под открытой лицензией, с доступными картами моделей, скриптами оценки и весами для вывода на Hugging Face:

- OpenReasoning-Nemotron-1.5B

- OpenReasoning-Nemotron-7B

- OpenReasoning-Nemotron-14B

- OpenReasoning-Nemotron-32B

Модели совместимы с фреймворком NVIDIA NeMo, а также поддерживают TensorRT-LLM, ONNX и Hugging Face Transformers, что упрощает их внедрение в производственные и исследовательские проекты.

Основные сценарии использования

- Математические репетиторы и решатели теорем

- Научные QA-системы и медицинская диагностика

- Генерация и отладка кода

- Многоэтапные вопросы с цепочкой рассуждений

- Создание синтетических данных для структурированных областей

Заключение

OpenReasoning-Nemotron от NVIDIA предлагает практичный open-source-подход к масштабированию логического мышления без затрат на сверхмощные вычисления. Благодаря дистилляции из 671B DeepSeek R1 и фокусировке на ключевых областях, эти модели обеспечивают оптимальный баланс точности, эффективности и доступности.

Для разработчиков, исследователей и компаний, работающих над логически сложными задачами, OpenReasoning-Nemotron представляет мощную основу — без компромиссов, характерных для проприетарных или излишне обобщённых моделей.

Какие тесты поддерживаются?

GPQA, MMLU-PRO, HLE, LiveCodeBench, SciCode, AIME 2024/25, HMMT Feb 2025 (pass@1).

Какой объём данных использовался?

Дистиллированный набор из 5 миллионов примеров логических рассуждений, сгенерированных DeepSeek‑R1‑0528.

Используется ли обучение с подкреплением?

Нет — модели обучались только через SFT, сохраняя эффективность для будущих исследований RL.

Можно ли улучшить результаты с GenSelect?

Да. Например, 32B-модель улучшает результат с 73.8 до 96.7 на HMMT при 64 кандидатах.

Полина Сергеева

AI-разработчик и технический писатель. Создаёт инструменты на базе нейросетей и делится практическими гайдами для разработчиков и бизнеса.