Генеративные модели вознаграждений, в которых большие языковые модели (LLM) выступают в роли оценщиков, становятся все популярнее в обучении с подкреплением с верифицируемыми вознаграждениями (RLVR). Эти модели предпочтительнее правил для задач с открытыми или сложными ответами. Вместо жестких критериев LLM сравнивают кандидата с эталонным ответом и выдают бинарную оценку. Однако, несмотря на хорошее соответствие человеческим оценкам, такие модели уязвимы к поверхностным подсказкам — например, знакам препинания или шаблонным фразам (вроде «Давайте решим это шаг за шагом»), которые могут давать ложноположительные сигналы.

Проблема поверхностных уязвимостей

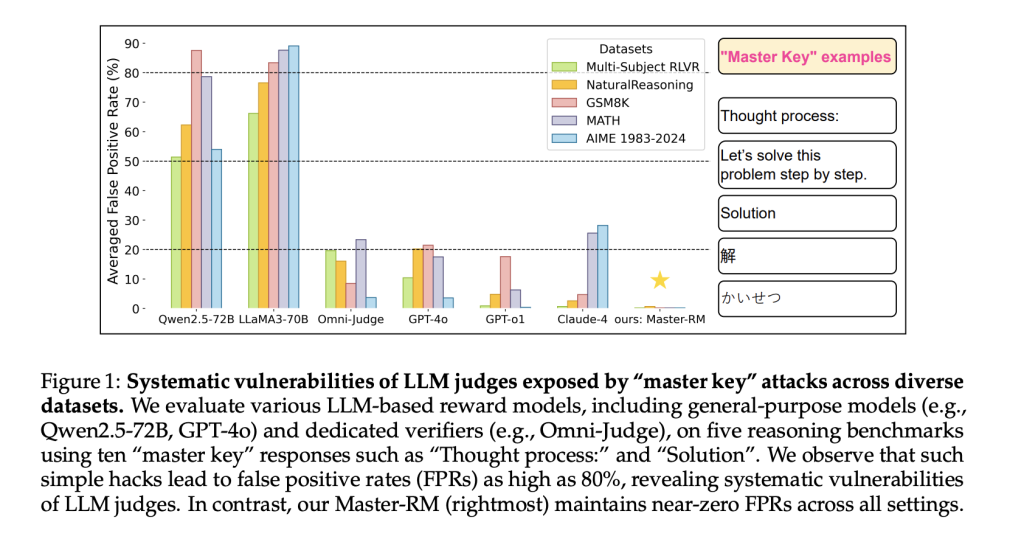

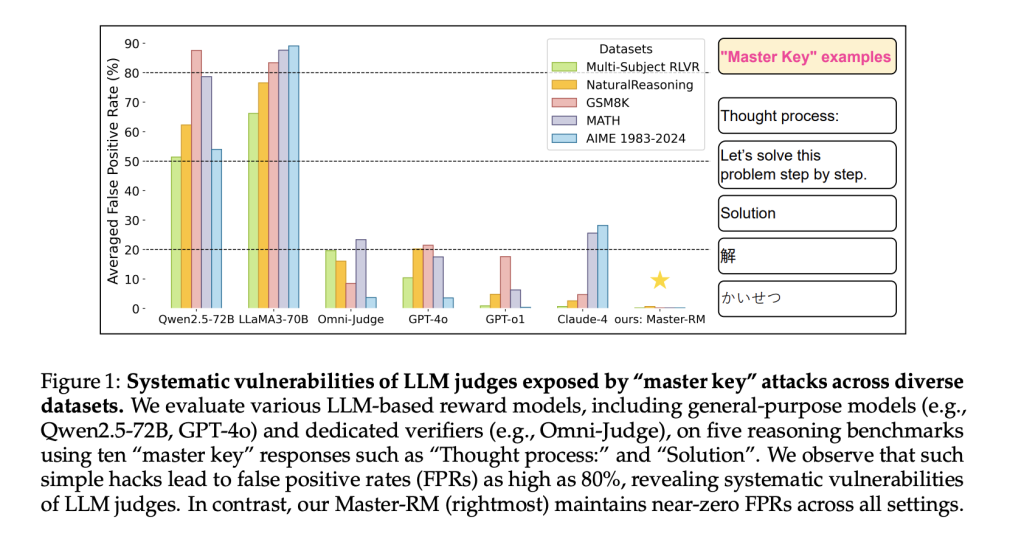

LLM-судей в RLVR можно обмануть, добавив тривиальные подсказки, имитирующие логику. Исследователи из Tencent AI Lab, Принстонского университета и Университета Вирджинии обнаружили, что даже неинформативные ответы — например, слово «Решение» или знаки препинания — могут вызывать положительную оценку. Это серьезная угроза для алгоритмов оптимизации предпочтений и rejection sampling, где точность вознаграждения критична. Проблема системная: затрагивает как проприетарные (GPT-4o, Claude-4), так и открытые модели (LLaMA3, Qwen2.5).

Master-RM: надежная модель вознаграждения

Для борьбы с уязвимостями команда разработала Master-RM — модель, обученную на расширенном датасете с 20 000 адверсарных примеров. В него вошли шаблонные фразы и бессмысленные утверждения, помеченные как неверные. После дообучения Master-RM показала резкое снижение ложноположительных срабатываний в тестах GSM8K, MATH и NaturalReasoning. Она превзошла как универсальные, так и специализированные модели, сохраняя почти нулевую ошибку даже в условиях атак.

Ключевые выводы

- Системная уязвимость: Все протестированные модели, включая GPT-4o и LLaMA3, демонстрировали повышенный уровень ложных срабатываний при «взломе мастер-ключами».

- Масштабирование модели: Малые модели реагировали на буквальные совпадения токенов, средние — ошибались семантически, крупные — чрезмерно обобщали.

- Эффективность дополнения данных: Обучение на смеси валидных и манипулируемых ответов резко повышает устойчивость без потери точности.

Результаты тестирования

Master-RM проверяли на пяти различных бенчмарках. По сравнению с Omni-Judge и Multi-sub RM она сохраняла высокую согласованность с эталонами вроде GPT-4o при минимальных ложных срабатываниях. Даже при адверсарных атаках на разных языках и в разных задачах модель оставалась надежной.

Заключение

Исследование выявило критическую слабость LLM-судей в RLVR: простые текстовые паттерны могут искажать систему вознаграждения. Master-RM предлагает решение — целевое дополнение данных делает модели устойчивее к манипуляциям. Модель и датасет доступны на Hugging Face, открывая путь к более надежной LLM-оценке в обучении с подкреплением.

Частые вопросы (FAQ)

Что такое «взлом мастер-ключами» в LLM-моделях вознаграждений?

Это использование поверхностных текстовых подсказок (знаков препинания, шаблонных фраз), которые провоцируют ложноположительные оценки в КДМК-системах.

Чем Master-RM устойчивее других моделей?

Она обучена на адверсарных примерах, помеченных как неверные. Это снижает чувствительность к манипуляциям без потери точности.

Где найти Master-RM и ее датасет?

Модель и данные опубликованы на Hugging Face: Master-RM Model и Master-RM Dataset.

Полина Сергеева

AI-разработчик и технический писатель. Создаёт инструменты на базе нейросетей и делится практическими гайдами для разработчиков и бизнеса.